会社 Apple iCloud にアップロードされた写真や iMessage のチャットをスキャンして、違法な性的コンテンツの兆候を検出するシステムである、子供の違法な写真をスキャンする機能の開始を取りやめました。 先月発表されたこのシステムは、クラウドにアップロードされた違法な写真の兆候を探すために、児童の性的虐待資料 (CSAM) のサードパーティ データベースを使用することになっていたが、すぐに 抵抗に会った プライバシー擁護者による。

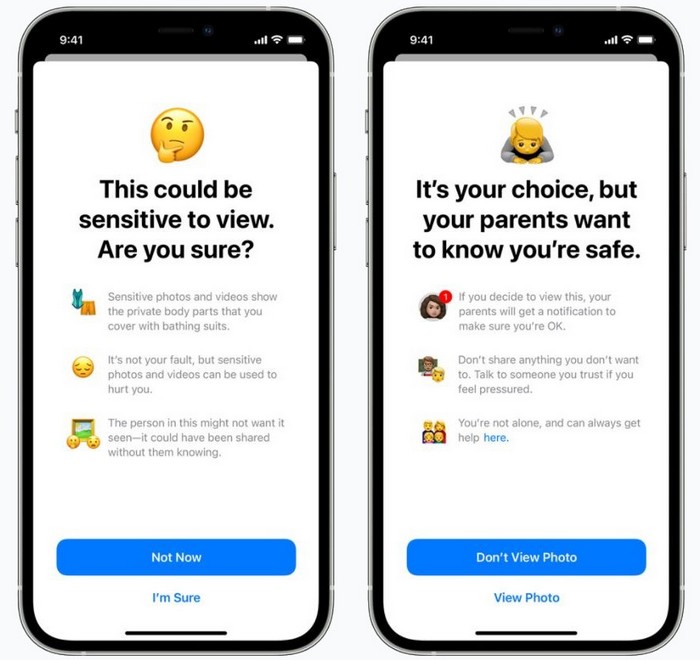

混乱は、次の事実によって悪化しました。 Apple は実際には つのシステムを同時に発表しましたが、それらの機能は多くの場所で混在していました。 つには、iMessage は画像認識を使用して、若いユーザーとの会話で共有されている可能性のある率直な写真にフラグを立てます。 そのような画像が公開されると、自動的に検閲され、オプションとして保護者にその内容が通知されます。

同時に、別のシステムが CSAM をチェックします。 同社の iCloud Photos サービスにアップロードされた画像のみが監視される Apple、同様の違法コンテンツのデータベースに基づいて専門機関によって作成された指紋画像を使用します。 そのような画像が複数検出された場合、 Apple そのようなユーザーを当局に報告します。

プライバシーとセキュリティの懸念を考慮し、 Apple いくつかの警告を提供しました。 同社によると、スキャンはリモートではなくデバイス上で行われ、画像が比較される指紋には違法なコンテンツは含まれていません。 アップロードされた画像にフラグが付けられた場合でも、レポートが編集される前に人間によって確認されます。

ただし、これらの革新の反対者は決定されました。 システム Apple クパチーノ社は、反対の主張をしているにもかかわらず、間違いなく法執行機関や政府からの圧力に直面するだろう. 若者も危険にさらされる可能性があり、プライバシーの権利が侵害される可能性があることが指摘されました。 Apple は、iMessage スキャン システムを介して誤って LGBT として両親に渡します。

会社の従業員、管理者から入手した非公式情報によると、 Apple 反動の規模とそれがどれだけ続いたかに唖然としました。 今 Apple は、今年、iOS 15、iPadOS 15、watchOS 8、macOS Monterey と並んで新しいシステムをリリースしないことを確認しました。

「先月、私たちはコミュニケーションツールを使って勧誘や搾取を行う捕食者から子どもたちを保護し、子どもの性的虐待資料の配布を制限するために設計された機能を実装する計画を発表しました」と声明は述べている。 Apple. 「顧客、擁護団体、研究者などからのフィードバックに基づいて、これらの重要な子供の安全機能をリリースする前に、今後数か月間、情報を収集して改善するためにさらに時間を費やすことにしました。」

明確にするために、私たちは新しいCSAMシステムの完全なキャンセルについて話しているのではなく、単に遅れているだけです. しかし、子供たちを略奪行為から保護する必要性を認識しながらも、広範なスキャンがそれを行うための最良の方法であると疑っているプライバシー擁護者からは、おそらく勝利と見なされるでしょう.

また読む: