人工知能(AI)技術の創造と開発を専門とする教授、開発者、エンジニアの会議が5月8日から日までカリフォルニアで開催された。 日間の活発な議論の中で、現在すでに使用されており、将来使用されるべき AI 原則のリストがまとめられました。実際、過去数十年にわたって人類が機械学習の分野で達成してきたことの概要がまとめられています。

一般に、「人工知能」は人間の脳や知能そのものとは直接関係がありません。この用語の作者であるアメリカのコンピュータ科学者ジョン マッカーシーは、この概念を次のように解釈しています。私たちは知性のメカニズムの一部しか理解していません。したがって、この科学の範囲内での知性とは、世界の目標を達成する能力の計算要素のみを意味します。これは1956年にダートマス大学の会議で発表された。

時がマッカーシーの言葉を裏付けた。今日、私たちは目標を達成するために情報ツールを使用しており、世界を簡素化することや未来について考えることについてのアイデアは、ソフトウェア コードとますます密接に関連しています。はい、同じ作品の考え方を変更しましたが、その遍在性を完全に排除したわけではありません。

そこで、編集された 23 の「未来の法則」すべてが、科学と研究の問題、倫理と価値観、技術的観点の つのグループに分けられました。

人工知能の憲法

研究セグメント

- 人工知能研究の目的は、狭い範囲に焦点を当てたデバイスを作成するだけでなく、社会全体に利益をもたらすことです。

2. AI への投資は、テクノロジーの有用性を確保するために研究分野に投入され、コンピューター サイエンス、経済学、法律、倫理、社会科学の新たな疑問に対してより正確かつ一般化された答えを与えることができるようにする必要があります。

- AI の高い信頼性を確保し、ハッカーのハッキングにうまく抵抗し、新たな誤動作を簡単に防ぐにはどうすればよいでしょうか?

- 自動化の助けを借りて、最小限のリソースを費やして必要な目標を達成するにはどうすればよいでしょうか?

- 法制度を正しく更新し、現代の規範に従って正義を確保し、AIの出現を考慮に入れるにはどうすればよいでしょうか?

- AI はどのような法的および民族的地位を得るでしょうか?

3. 研究者と政治家との間の建設的で平等な相互作用を確保する。

4. AI のさらなる利用に向けた文化の完全なオープン性と透明性が達成されました。

5. 激しい競争を避けるための AI 研究者間の交流と協力。

道徳的価値観

6. 人工知能システムは、運用期間全体を通じて安全で信頼性がなければなりません。

7. 問題の原因を最大限迅速に解明し、さらなる排除を行う。

8. 裁判所の決定に対する自治制度の介入は認可され、委員会の有能な委員(人)による検証の場合には報告の対象となるべきである。

9. 設計またはソフトウェアのエラーによって引き起こされる損害、または意図的に危険な状況を作り出した場合の責任は、開発者とエンジニアの肩にあります。

10. すべての自律型 AI システムは、普遍的価値の知識を得るように努めなければなりません。

11. AI は、人間の尊厳、権利、自由、文化的多様性の理想と両立するような方法で設計および運用されなければなりません。

12. 個人が AI を使用する過程で生じた情報は、将来その同じ人が利用できるようにする必要があります (結果や収集されたデータを廃棄する可能性)。

13. 個人データを扱う AI は、人々の現実的または想像上の自由を不当に制限してはなりません。

14. AI テクノロジーは、できるだけ多くの人が恩恵を受け、利用できるようにする必要があります。

15. AI の経済的および社会的成果は平和的であると考えられており、人類の利益に向けられなければなりません。

16. 人には常に選択肢があります。自分で決定を下すか、AI に決定を委ねるかです。

17. AI の目標は、破壊や大惨事を引き起こすことなく社会を改善し、豊かにすることです。

18. 軍拡競争で AI 技術が使用される可能性はゼロになるべきであり、実際、武力競争も終結すべきである。

長期にわたる質問

19. リソースの不合理な支出を避けるために、私たちは AI の能力の限界を絶対に冷静に評価しなければなりません。

20. AI の開発は集中的に行われるため、不可逆的な反応を引き起こさないようにテクノロジーを制御する必要があります。

21. リスク、特に大規模なリスクは、起こり得る損害を確実に最小限に抑えるような方法で計画されなければなりません。

22. AI システムは自己発展と自己再生産が可能であり、AI 活動の質の低下を引き起こす可能性があるため、主要な指標の定期的なモニタリングを実行する必要があります。

23. スーパーインテリジェンスは、特定の民間組織や国家の影響を受けず、全人類の利益に役立つ、そして今後も役立つテクノロジーです。

また読んでください: ハイパーループ: 真空列車レースはどうですか?

レポートの主要なテーマを見てみましょう。専門家はAIの集中的な開発において自らの後進性を懸念し、技術を絶対的にコントロールしようと努める。また、AI の世界的な公共的価値と人間文化との関連性も繰り返し強調されています。ただし、この計画が実行されるかどうかはすぐにわかります。人工知能は子犬のようなもので、今は走り回ったり、はしゃいだりしますが、最終的にどのような犬になるかは主に飼い主に依存します。

現時点では、この「法案」は地球国民による承認の段階にあります。安全で幸せなテクノロジーの未来を望むのであれば、ご自由にどうぞ "投票する" これらの絶対に合理的で必要な原則を採用したことに対して。

チューリングテスト

偉大な数学者アラン・チューリングも AI テクノロジーに関わっていたため、非常に興味深いテストを考案しました。チューリング テストは、1950 年に哲学出版物『マインド』の記事「コンピューティング マシンと心」で初めて紹介されました。このテストの目的は、機械的思考の能力、そして一般的にはその存在自体を判断することです。

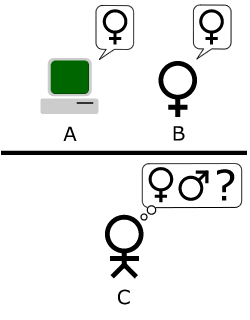

標準的な解釈は次のとおりです。「人は 1 台のコンピュータと 1 人の人間と対話します。質問への答えに基づいて、彼は誰と話しているのか、つまり人間なのか、それともコンピュータ プログラムなのかを判断する必要があります。コンピュータープログラムの使命は、人を誤解させ、間違った選択を強いることです。」テストの目的は物体認識装置の技術的能力をテストすることではなく、むしろ人間の心を模倣する能力をテストすることであるため、参加者全員はお互いの顔を見ることはなく、コミュニケーションはテスト形式で行われます。

通信も制御された時間間隔で行われるため、「裁判官」が応答の速度に基づいて結論を下すことはできません。興味深いのは、このテストの作成時にはコンピューターの反応が人よりも遅かったという事実のためにこのルールが発明されたことですが、現在では人が遅れているため、これも必要です。

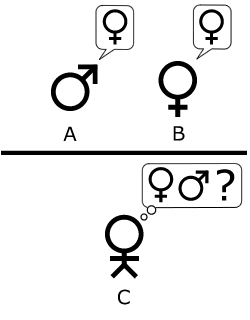

また、このテストに基づいて、対話者の性別を決定するために同様のテストが作成されました。裁判官の役割として、プレーヤー C はプレーヤー A と B、実際には男性と女性とコミュニケーションをとらなければなりません。

AI に関するある研究論文では、次のようなコメントがありました。「では、『このゲームでマシンがプレイヤー A として行動したらどうなるだろうか』と考えてみます。」あたかも男性と女性がテストに参加しているかのようにゲームがプレイされると、プレゼンターは誤った判断をしてしまうでしょうか?これらの質問は、「機械は考えることができますか?」という元の質問に置き換わるものです。

つまり、まったく突飛な質問を 1 つ答える代わりに、簡単な質問に答えて順番に答えていくことで、人工知能の思考能力に関する主要な質問に対する待望の答えにどんどん近づきます。